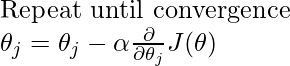

梯度下降 :

梯度下降是一种优化算法,用于找到最小化成本函数的函数参数值。它是一种迭代算法。我们使用梯度下降来更新模型的参数。参数是指线性回归中的系数和神经网络中的权重。

即使学习率保持固定,梯度下降也可以收敛。

正规方程:

正态方程,一种用于优化的分析方法。它是梯度下降的替代方案。正规方程无需迭代即可执行最小化。

正规方程是通过将误差平方和或代价函数的偏导数设为零而得到的方程;正规方程允许人们估计多元线性回归的参数。

在哪里

X = 输入特征值

y = 输出值

如果术语![]() X 是不可逆的或奇异的,那么我们可以使用正则化。

X 是不可逆的或奇异的,那么我们可以使用正则化。

梯度下降和正态方程之间的区别。

| S.NO. | Gradient Descent | Normal Equation |

|---|---|---|

| 1. | In gradient descenet , we need to choose learning rate. | In normal equation , no need to choose learning rate. |

| 2. | It is an iterative algorithm. | It is analytical approach. |

| 3. | Gradient descent works well with large number of features. | Normal equation works well with small number of features. |

| 4. | Feature scaling can be used. | No need for feature scaling. |

| 5. | No need to handle non-invertibility case. | If ( |

| 6. | Algorithm complexity is O(k n is the number of features. |

Algorithm complexity is O( n is the number of features. |