正则方程是具有最小二乘成本函数的线性回归的一种分析方法。我们可以不用Gradient Descent直接找出θ的值。当使用具有小特征的数据集时,采用这种方法是一种有效且省时的选择。

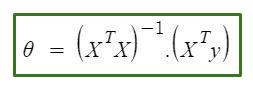

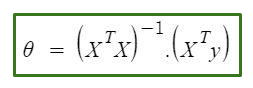

正规方程如下:

在上式中

θ:定义最佳的假设参数。

X:输入每个实例的特征值。

Y:每个实例的输出值。

方程背后的数学–

给定假设函数![]()

在哪里,

n:不。数据集中的特征。

x 0 : 1(用于向量乘法)

请注意,这是θ和x值之间的点积。因此,为了方便解决,我们可以将其编写为: ![]()

线性回归的动机是使成本函数最小化:

在哪里,

x i : i ih训练示例的输入值。

m:不。训练实例

n:不。数据集功能

y i :第i个实例的预期结果

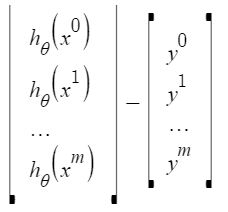

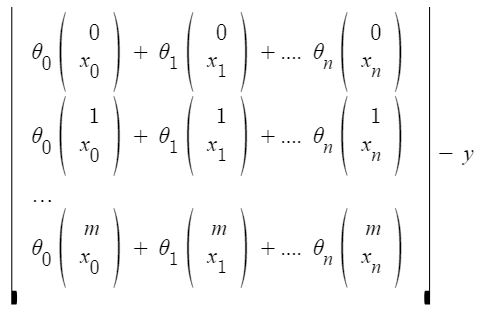

让我们以向量形式表示成本函数。

我们在这里忽略了1 / 2m,因为它不会对工作产生任何影响。它在计算梯度下降时用于数学上的便利。但是这里不再需要。

x i j : i ih训练示例中j ih特征的值。

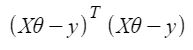

这可以进一步简化为![]()

但是每个残差值都是平方的。我们不能简单地将上述表达式平方。因为向量/矩阵的平方不等于其每个值的平方。因此,要获得平方值,请将向量/矩阵与其转置相乘。因此,得出的最终方程为

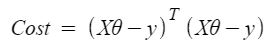

因此,成本函数为

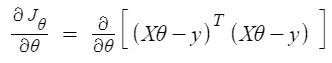

因此,现在使用导数获得θ的值

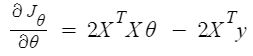

![]()

![]()

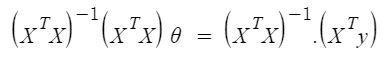

![]()

因此,这是最终得出的正规方程,其中θ给出最小成本值。