短期记忆

在更广泛的神经学家和研究大脑的社区中,人们一致认为,两个暂时不同的过程有助于大脑功能的获得和表达。这些变化可能导致神经元操作的长期改变,例如通过突触传递中的活动依赖性变化。现在有强有力的证据表明一个互补的过程,在称为短期记忆或 STM 的中间时间尺度上起作用。执行需要临时存储和操作以指导适当操作的任务的过程。

以下是在学习 STM 时应解决的一些重要问题:

- 如何选择神经信息进行存储并临时存储在 STM 中以备将来在感觉运动事件的时间序列中使用?

- 如果未来的用途未知,我们如何决定缓冲大量存储?

- 如何构建时间序列的 LTM 表示,STM 选择的信息如何转移到 LTM?

在本文中,我们将讨论 LSTM,它是 STM 的一个流行用例。我们还将讨论 LSTM 中的不同变体。

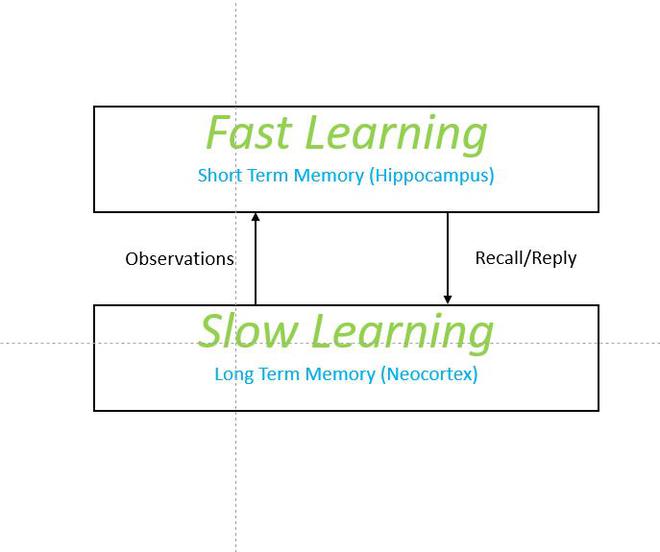

补充学习系统

在生物学背景下,短期记忆以大脑的海马结构为模型,它存在于大脑的互补学习系统中,该系统包含海马结构和新皮层两部分。在这里,新皮层充当传统的长期记忆,但 HF 快速学习不同的观察结果,形成更稀疏、不重叠、因此无干扰的表征,起到短期记忆 (STM) 的作用。受此启发的架构是人工海马算法,我们在本文中讨论过。

LSTM

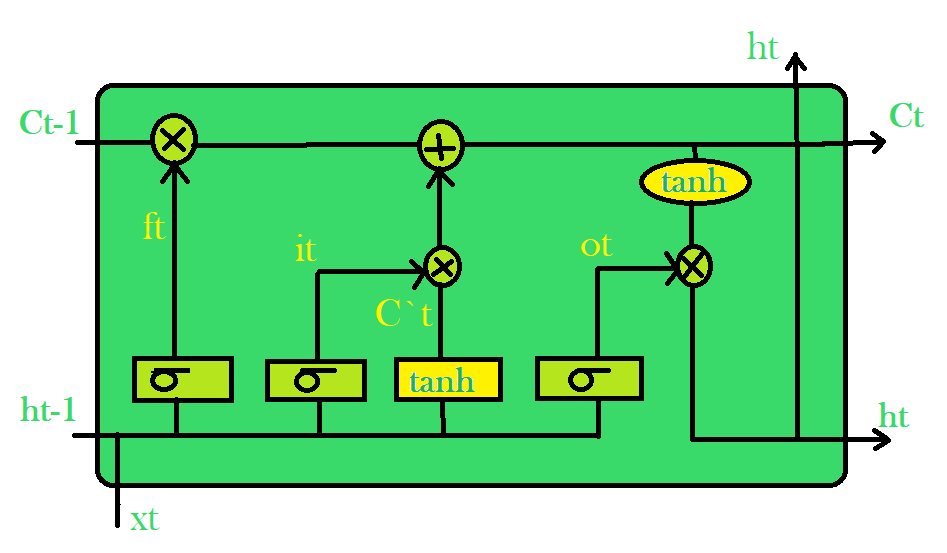

LSTM 是由 Sepp Hochreiter 和 Jurgen Schmidhuber 在 1990 年代提出的。这背后的主要思想是纠正 RNN 在某些情况下的失败。它无法长时间存储信息。有时,需要参考很久以前存储的某些信息来预测当前输出。但是 RNN 绝对无法处理这种“长期依赖”。下面是 LSTM 的架构:

LSTM架构

每个 LSTM 单元有两个输入,前一个单元状态 C t-1的输出、隐藏状态 h t-1和输入状态 x t 。在第一个 sigmoid 层,它传递输入 x t和隐藏单元 h t-1 。它的输出是遗忘门 f t 。在下一层,将输入 x t和隐藏单元 h t-1串联起来,分别通过 sigmoid 层和tanh层,并应用逐点乘法将它们组合起来,这就是输入门。在输出门中,我们只采用输入门中使用的输入的 sigmoid 并应用与单元状态的tanh 的逐点乘法。有关 LSTM 的更多详细信息,请查看这篇文章。

在下一节中,我们将讨论基于 LSTM 的架构:

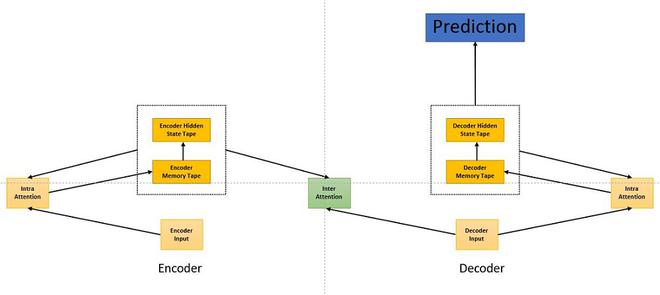

浅注意力融合和深度注意力融合

Shallow attention fusion 将 LSTM-N(类似于 LSTM,除了用内存网络替换了内存单元)作为一个单独的模块,可以很容易地在编码器-解码器架构中使用,代替标准的 RNN 或 LSTM。解码器和编码器都由内部注意模块塑造。当解码器读取与其相似的目标标记时,会触发 Inter attention。

浅注意力融合

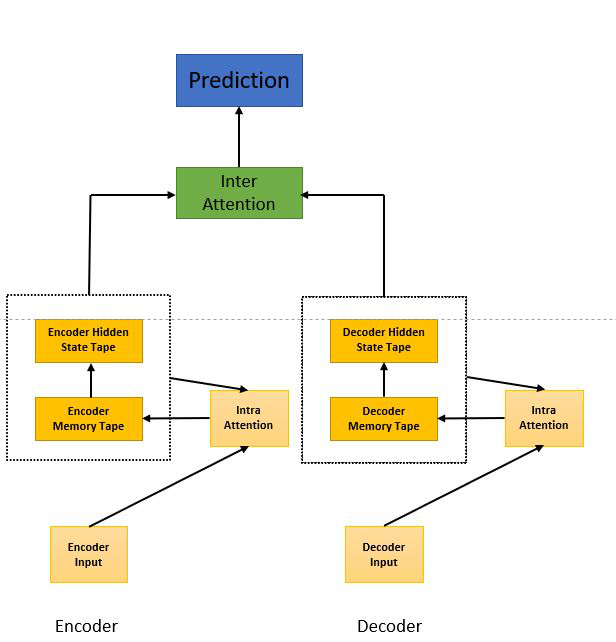

深度注意力融合在计算状态更新时结合了注意力间和注意力内。这里,inter-attention 作为连接 b/w 编码器和解码器架构,与浅层注意力融合不同,这里的输出是由解码器而不是内部注意力模块生成的。

深度注意力融合

参考:

- 短期记忆