多变量优化 – Gradient 和 Hessian

在多元优化问题中,有多个变量充当优化问题中的决策变量。

因此,当您查看这些类型的问题时,一般函数z 可能是决策变量 x 1 、x 2 、x 3到 x n 的一些非线性函数。因此,可以操纵或选择 n 个变量来优化此函数z。请注意,可以使用二维图片来解释单变量优化,因为在 x 方向上我们有决策变量值,而在 y 方向上我们有函数值。但是,如果是多变量优化,那么我们必须使用三个维度的图片,如果决策变量大于2,则很难可视化。

坡度:

在解释梯度之前,让我们先对比一下单变量情况的必要条件。因此,在单变量优化的情况下,x 成为函数f(x) 的最小值的必要条件是:

因此,一维情况下的导数成为我们所说的多元情况下的梯度。

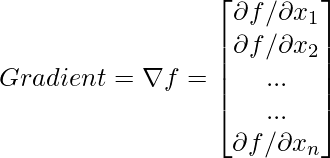

根据单变量优化中的一阶必要条件,例如 f'(x) = 0 或一个也可以将其写为df/dx 。然而,由于在多元情况下有很多变量,我们有很多偏导数,并且函数f 的梯度是一个向量,这样在每个分量中都可以计算函数相对于相应变量的导数。所以,例如, ![]() 是第一个组件,

是第一个组件, ![]() 是第二个组件,并且

是第二个组件,并且![]() 是最后一个组件。

是最后一个组件。

Note: Gradient of a function at a point is orthogonal to the contours.

黑森州:

类似地,在单变量优化的情况下,x 是函数f(x) 的最小值的充分条件是:

二阶充分条件:f”(x) > 0 或 d 2 f/dx 2 > 0